Dify

Dify 是一个开源的 LLM 应用开发平台,让您能够快速搭建 AI 应用。通过 API易,您可以在 Dify 中使用各种主流 AI 模型。快速集成

1. 获取 API 密钥

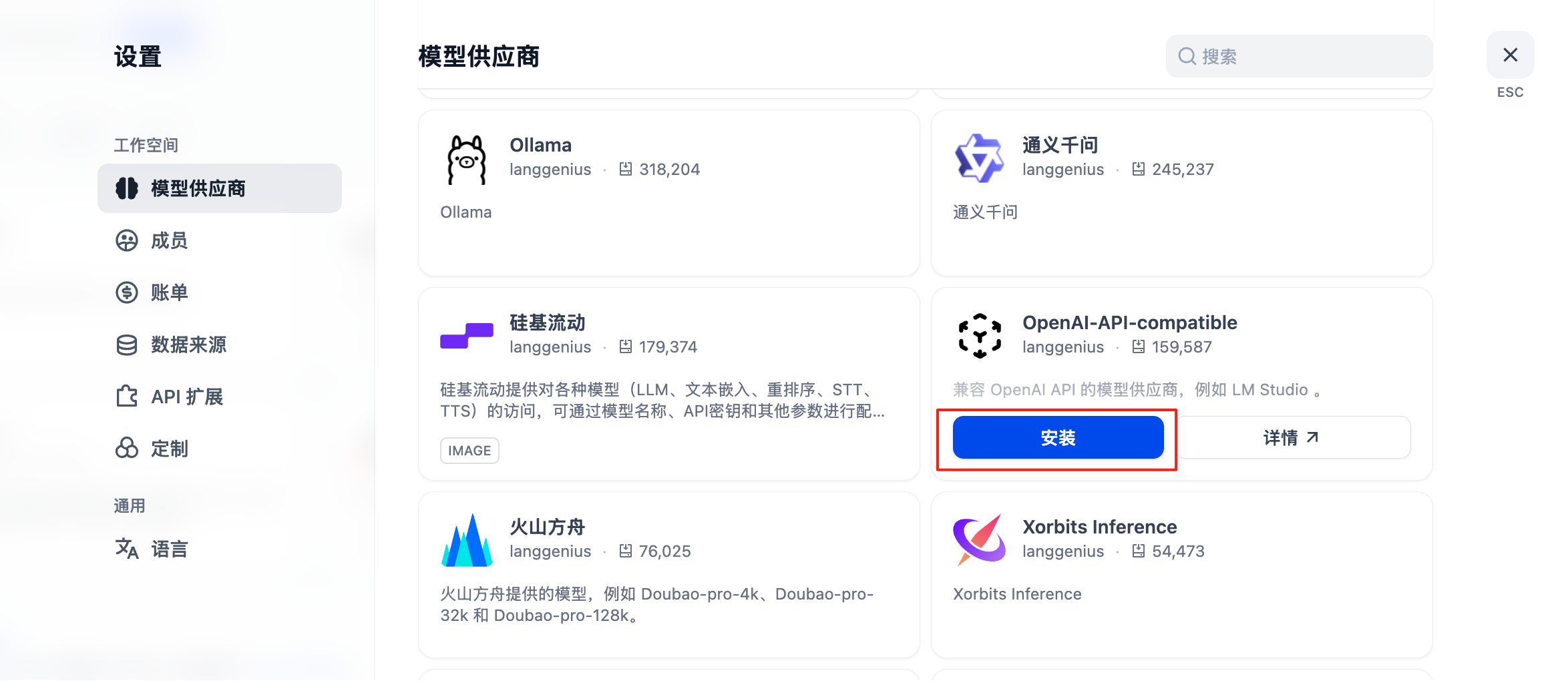

访问 API易控制台 获取您的 API 密钥。2. 配置模型供应商

- 登录 Dify 平台

- 点击用户名 > 设置

- 选择”模型供应商” - 选择 OpenAI-API-compatible

- 根据模型类型选择配置方式

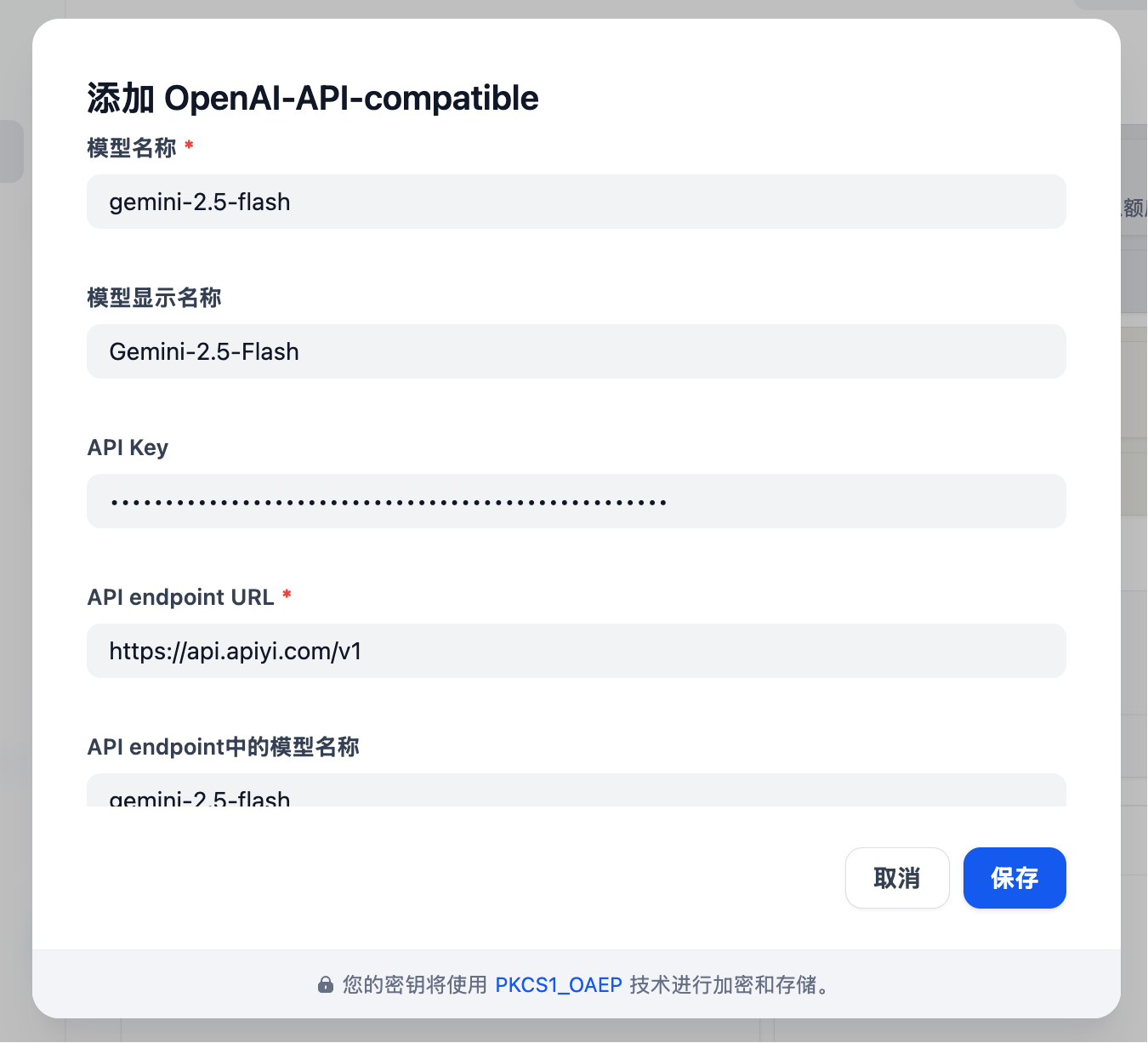

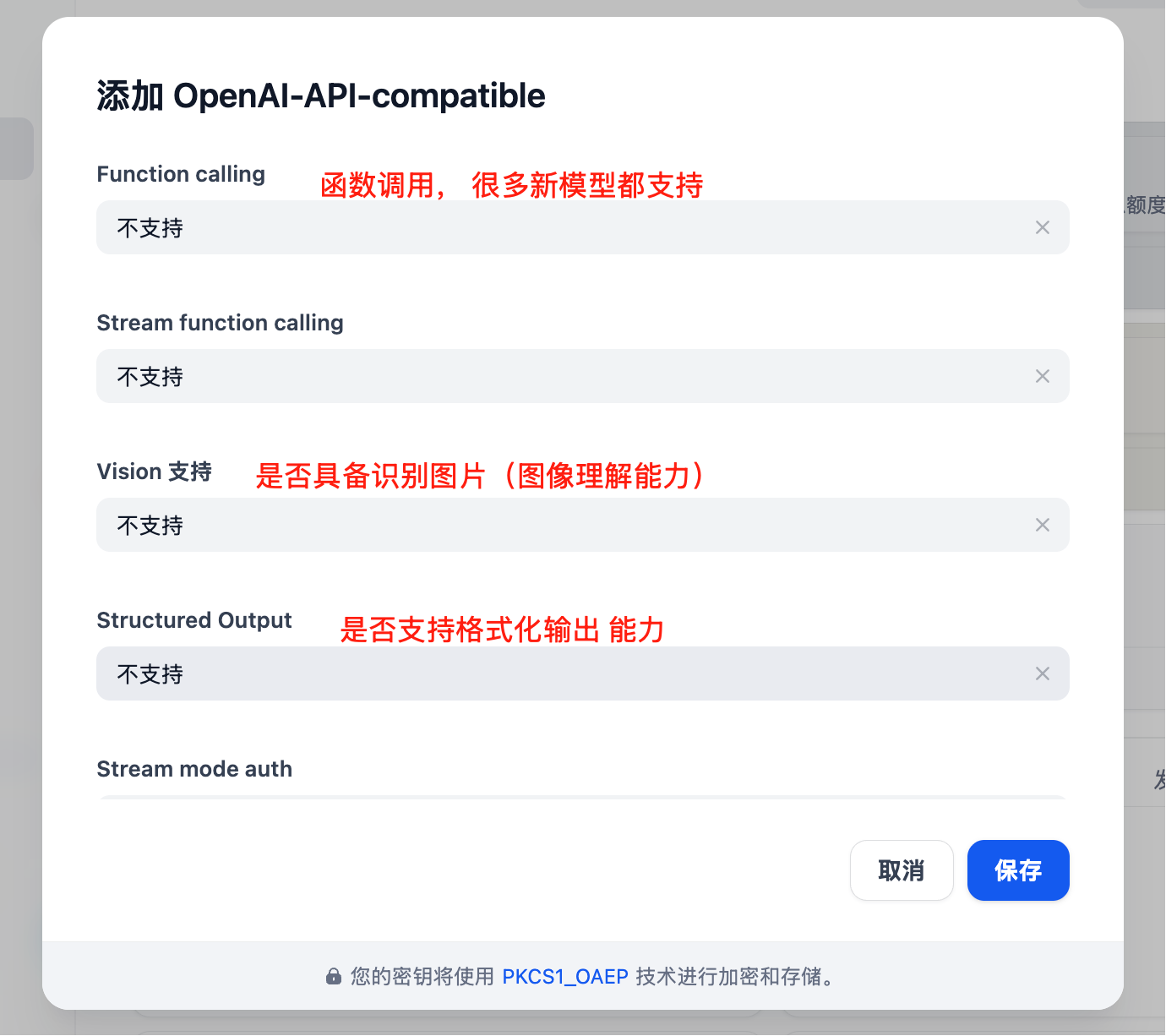

所有模型,包括 GPT、Claude、Gemini 模型配置

- 模型类型:选择 LLM 类型(第一个栏目,图略)

-

模型名称:需要输入模型规范名称,不能乱输入

- 举例:输入 gemini-2.5-flash 而不能输入 Gemini 2.5 Flash。

- 模型显示名称:可以随意,方便辨识即可,比如可以写 Gemini 2.5 Flash

- API Key:输入 API易 密钥

-

API endpoint URL:

https://api.apiyi.com/v1 - API endpoint中的模型名称,写规范名称:gemini-2.5-flash

核心功能

对话助手

创建智能对话助手:- 选择”对话助手”模板

- 配置系统提示词:

- 选择合适的模型(如 GPT-4)

- 调整参数:

- 温度:0.7(平衡创造性和准确性)

- 最大输出:2000 tokens

工作流应用

构建复杂的 AI 工作流:知识库问答

集成文档知识库:- 创建知识库

- 上传文档(PDF、Word、Markdown)

- 选择嵌入模型:

text-embedding-ada-002 - 在应用中引用知识库

- 配置检索参数:

- 检索数量:3-5 个片段

- 相似度阈值:0.7

- 重排序:开启

应用类型

1. 聊天助手

2. 文档分析

3. 代码助手

高级功能

API 集成

Dify 应用可以通过 API 调用:批量处理

处理大量数据:- 准备 CSV 文件

- 创建批处理任务

- 配置处理模板

- 执行批量任务

- 导出结果

多模态应用

支持文本和图像的混合处理:模型选择策略

按场景选择

查看场景化模型推荐

查看最新的场景化模型推荐,包括文本创作、编程开发、快速响应、长文本处理等全场景的最佳模型选择。

为什么不在此列出具体模型?AI 模型更新迭代速度非常快,为了确保您获取最准确的模型推荐信息,我们统一在 模型推荐页面 维护最新的模型列表、性能数据和使用建议。

成本优化

最佳实践

1. 提示词优化

2. 工作流设计

3. 监控和优化

定期检查:- 用户满意度反馈

- 响应时间统计

- 成本使用情况

- 错误率分析

4. 版本管理

- 定期备份应用配置

- 测试新版本后再发布

- 保留多个版本以便回滚

故障排除

常见问题

模型调用失败

- 检查 API 密钥正确性

- 确认账户余额充足

- 验证网络连接

响应质量差

- 优化提示词设计

- 调整模型参数

- 增加上下文信息

性能问题

- 选择更快的模型

- 减少输出长度限制

- 启用缓存功能

性能优化

部署建议

生产环境

安全配置

- 使用环境变量存储敏感信息

- 启用 HTTPS 访问

- 设置访问权限控制

- 定期更新依赖包